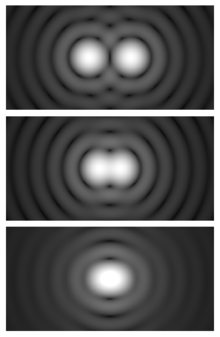

Ilustracja kryterium Rayleigh’a: górny obrazek – źródła rozdzielone, środkowy – na granicy rozdzielczości, dolny – źródła nie do rozdzielenia tradycyjną metodą. Źródło – Wikipedia.

Czcigodny Czytelnik, śledząc zapierające dech w piersiach odkrycia naukowców w dziedzinie astronomii i astrofizyki zadał sobie – lub prędzej czy później zada – pytanie „A właściwie dlaczego potrzebujemy teleskopów do obserwacji?“. Nie wnikam nawet, czy kosmicznych czy naziemnych. Po prostu „jaką przewagę daje nam teleskop?“. Nad czym? Oczywiście, nad tym co mamy od Stwórcy – ludzkim okiem.

Jak wiemy, ludzkie oko dla poznania Kosmosu zrobiło bardzo wiele (w tandemie z mózgiem). Istotne dla nas są: rozmiar źrenicy (określający rozdzielczość) i czułość siatkówki. Odpowiednie ryciny i opis ludzkiego oka można znaleźć w większości poradników medycznych. Dla astronomów szczególnie istotne są czopki (komórki barwoczułe, odpowiadające za widzenie barw) i pręciki (komórki postrzegające natężenie światła, bez określania długości jego fali, tj. barwy). Z powodu faktu, że czopki są mniej czułe niż pręciki, mawiamy że „w ciemności wszystkie koty są szare“. To ładne stwierdzenie odzwierciedla fakt, że w warunkach słabego oświetlenia widzimy światło bez możliwości dokładnego określenia jego barwy. Dopiero dla jaśniejszych źródeł skłaniamy się do podania koloru. Czyli czego? Ano, właśnie owej tajemniczej długości fali.

Ilustracja wpływu turbulencji atmosferycznej (dającej zjawisko seeingu) na obserwacje. Żródło – Innovations Foresight.

Siatkówka i źrenica odpowiadają też za główne niedoskonałości oka które skłoniły astronomów (jako pierwszego, Galileusza) do konstruowania instrumentów pozwalających je ominąć bądź przekroczyć. Mniej więcej 400 lat temu (dokładnie, w 1609 roku) Galileusz złożył tor optyczny pierwszego teleskopu (w polskiej terminologii to luneta – bo oparta o soczewki, nie o zwierciadło). Miał on soczewkę o ok. 4 cm średnicy. Pozwoliło to temu Astronomowi (piszę przez duże „A“, bo odkrycia swe przypłacił niemal życiem a jednak się z ich interpretacji nie wycofał) zobaczyć pierścienie Saturna i księżyce Jowisza po dziś dzień zwane galileuszowymi: Io, Europę, Ganimedesa i Callisto. Dostrzegłszy taki układ księżyców Jowisza (zmieniających całkiem prędko położenie) nie oparł się wrażeniu, iż jest to miniatura Układu Słonecznego. Z największym ciałem w centrum, wtedy – Jowiszem, u nas – Słońcem. Po kompletny opis tych czasów odsyłam do dawnych podręczników fizyki i astronomii, ja chciałbym się zająć ilościowym oszacowaniem rozdzielczości i czułości teleskopów, czyli wyjaśnieniem o ile teleskopy są lepsze od ludzkiego oka.

Jak wiemy, źrenica ludzka w ciemności, po godzinnej adaptacji ma szansę osiągnąć 8-9 mm średnicy. To w stosunku do rozmiaru całego oka sprawia, że jego rozdzielczość kątowa wynosi mniej więcej minutę łuku. Tyle, ile ma Wenus gdy jest w pobliżu Ziemi (tzw. złączenia dolnego), Saturn liczony razem z pierścieniami czy Jowisz w czasie opozycji. Te ciała (a także ich ruch na niebie, wszak planety to „gwiazdy błądzące“) przykuwały uwagę ludzi od starożytności. Ale dopiero wynalazek teleskopu pozwolił na sięgnięcie głębiej – po Urana (6 magnitudo) czy Neptuna (9 mag). Co znaczą owe „magnitudy“? Wielkości gwiazdowe skalowane – a jakże – możliwościami ludzkiego oka. 0 magnitudo oznacza najjaśniejsze gwiazdy stałe (wyłączając Słońce, Księżyc i planety) a +6 mag – najsłabsze widoczne gołym okiem. Znacznie później zmierzono, że strumień energii od gwiazd zerowej wielkości jest około 100 razy większy od tego od gwiazd +5 wielkości. Oznacza to (po przeliczeniu), że różnicy +1 magnitudo odpowiada 2,5 raza słabszy strumień energii padającej na ziemski detektor (oko, kliszę CCD, matrycę, płytę fotograficzną…).

Pomalutku dochodzimy do meritum – wzoru na czułość (proporcjonalną do powierzchni źrenicy, zatem kwadratu jej promienia pomnożonego przez pi) i wzoru na rozdzielczość kątową, czyli minimalną odległość kątową dwóch obiektów które jeszcze będą dostrzegane jako podwójna gwiazda a nie zlane w jedną całość i nie do wyłapania oddzielnie. Tym, czy widzimy jedną czy dwie gwiazdy, rządzi kryterium Rayleigha. Wzór jest taki:

R = lambda/D

lambda jest długością fali, D – średnicą obiektywu (lub zwierciadła) teleskopu w tych samych jednostkach a R – odwrotnością rozdzielczości łuku w radianach. Radian to około 57 stopni kątowych, dokładnie 180/pi stopni.

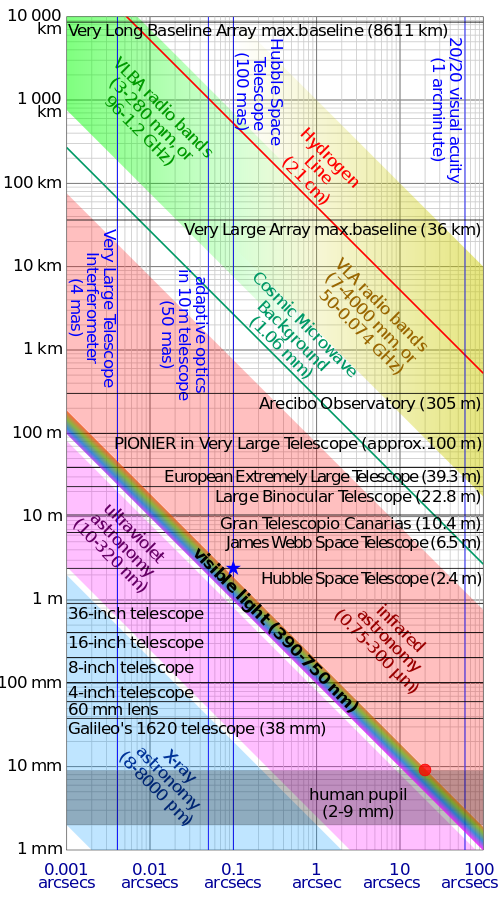

Co to oznacza? Że rozdzielczość rośnie ze wzrostem wielkości zwierciadła, ponadto maleje ze wzrostem długości fali. Uporządkujmy: im większa długość fali tym rozdzielczość mniejsza. Im większa średnica zwierciadła (dla pojedynczego instrumentu, lub długość bazy interferometru dla systemu teleskopów/anten) – tym rozdzielczość większa. Zatem rzecz idzie o poprawę stosunku długości fali do wielkości instrumentu bądź systemu instrumentów (o tym jeszcze poniżej) – aby był on jak najmniejszy. Czyli dla światła widzialnego (długość fali rzędu 1 mikrometra) rozdzielczość widziana danym instrumentem jest większa niż dla fali radiowej (np. wodoru, 21 cm) o tyle ile wynosi stosunek długości fal na których obserwujemy. Z kolei ludzka źrenica w ciemności ma 8 mm co jest wielkością wyjściową do określenia rozdzielczości instrumentu takiego jak np. teleskop Kecka (10 m średnicy), radioteleskop w Arecibo (na fale radiowe, więc trzeba jeszcze przeliczyć różnice „lambd“ widzialnej i radiowej, na niekorzyść radioteleskopu) czy interferometru VLA (Very Large Array), VLBI (Very Long Baseline Interferometry, radiowych), ALMA (Atacama Large Millimeter Array, milimetrowego a zatem „prawie“ widzialnego). Baza interferometru natomiast to maksymalne możliwe oddalenie – prostopadle do kierunku na obserwowany obiekt – instrumentów wchodzących w jego skład. Czyli dla VLA 36 km, dla VLBI 8611 km a dla Event Horizon Telescope – prawie średnicę Ziemi, rzędu 10000 km. Przewagą tego ostatniego jest niska wartość długości fal na których dokonywana jest obserwacja, wymaganiem – ogromna precyzja wykonania i posadzenia instrumentów.

The sky above Paranal on 21 July 2007. Two 8.2-m telescopes of ESO’s VLT are seen against the wonderful backdrop of the myriad of stars and dust that makes the Milky Way. Just above Yepun, Unit Telescope number 4, the Small Magellanic Cloud – a satellite galaxy of the Milky Way – is shining. A laser beam is coming out of Yepun, aiming at the Galactic Centre. It is used to obtain images that are free from the blurring effect of the atmosphere. On this image, the laser beam looks slightly artificial. This is a side effect due to saturation caused by the long exposure time. Planet Jupiter is seen as the brightest object on the upper right, next to the star Antares. Image taken by ESO astronomer Yuri Beletsky.

Chciałbym tutaj napomknąć o interferometrii – skąd wzięła się jej moc? Co powoduje, że do niedawna (w XX wieku) uważano, że ziemskie teleskopy ogranicza limit dyfrakcyjny w atmosferze (czyli seeing, około 1 sekundy kątowej) a teraz interferometry mają osiągnąć fantastyczne dokładności mikrosekund kątowych – setki tysięcy razy więcej? Pośrednim ogniwem były tutaj teleskopy z adaptywną optyką. Używano silnego lasera do wygenerowania sztucznej gwiazdy, poprzez analizę obrazu tej gwiazdy na ziemi ustalano kształt frontu fali dochodzącej do teleskopu w danym momencie (a zatem, stan atmosfery nad teleskopem) i błyskawicznie uwzględniano ten kształt (niejako go odejmując od kształtu idealnego zwierciadła, więc paraboloidy) nadając zwierciadłu odpowiedni profil przy pomocy systemu umieszczonych pod nim siłowników. Tak trzeba było robić setki/tysiące razy na sekundę. Czego do tego potrzebowano? Oprócz finezyjnych technologii optycznych – piekielnie szybkich komputerów. Im szybszych tym lepiej. Zyskiem całej tej operacji było poprawienie rozdzielczości o kilka razy w stosunku do tej bez odjętego seeingu.

Do osiągnięcia pełnej mocy interferometrii (optyka adaptywna nią nie jest) potrzebne było użycie systemu teleskopów/anten milimetrowych/anten radiowych jak jednego instrumentu. Co to oznacza? Konieczność śledzenia każdego frontu fali ze źródła i momentu osiągnięcia przezeń detektora każdego z instrumentów wchodzących w skład interferometru. To powoduje, że ilość danych jakie czasowo (przed tzw. redukcją, czyli stworzeniem spójnego obrazu źródła które obserwujemy) musimy przechować w pamięci komputera zwanego korelatorem jest iście kosmiczna. O ile wiem, pierwszym w Polsce instrumentem pracującym z sukcesem jako element interferometru VLBI był 32 m radioteleskop w Piwnicach pod Toruniem, zwany krótko RT-4. Był to olśniewający sukces dwóch-trzech pokoleń radioastronomów z Uniwersytetu Mikołaja Kopernika w Toruniu o którym można posłuchać w odcinkach magazynu „Astronarium“. Na koniec całej operacji interferometr daje obraz gwiazdy o rozdzielczości proporcjonalnej do odwrotności długości fali obserwacji (dlatego im dłuższa fala tym słabsza rozdzielczość) i czułości równej sumie kwadratów rozmiarów wszystkich instrumentów składowych przez kwadrat średnicy źrenicy ludzkiego oka. Czyli np. dla radioteleskopu w Arecibo czułość (305 m) przez 0.008 m, wszystko do kwadratu. Stąd jednostką czułości dla radioastronomii jest bardzo mała wartość zwana od wynalazcy radioastronomii (Karl) Jansky. Rozumiecie?

Czułość się sumuje, rozdzielczość przy interferometrze przyjmuje maksimum wielkości stosunku wielkości źrenicy do oddalenia skrajnych instrumentów oglądających dane (radio)źródło. Potencjał VLBI został w dużej mierze poznany, choć nowe odkrycia na innych falach (i rozwój tzw. astronomii wielozakresowej, multi-messenger astronomy) sprawiają że nie został on i nieprędko zostanie wyczerpany. Potencjał wspomnianego interferometru ALMA czy Event Horizon Telescope (będącego kombinacją instrumentów ulokowanych na Antarktydzie, na pustyni Atacama, w USA czy Europie) jest daleki od pełnego wykorzystania i dopiero najbliższe lata pokażą jak dalece front odkryć naukowych ulegnie przesunięciu. Czy obecne teorie naukowe to wytrzymają? Będzie okazja do pisania kolejnych doniesień i śledzenia odkryć których podłoże jest obserwacyjne ale interpretacja rodzi się w ludzkim umyśle. Obyśmy doczekali kolejnych sukcesów nauki w Polsce i na świecie.

Ilustracja zależności rozdzielczości od rozmiaru zwierciadła teleskopu/bazy interferometru i długości fali na której prowadzona jest obserwacja. ALMA ani Event Horizon Telescope nie zostały uwzględnione. By Cinglec – Own Work CC BY-SA 3.0.

Event Horizon Telescope w swojej pierwszej kampanii obserwacyjnej zbierał dane na temat ścisłego otoczenia centrum Galaktyki – czarnej dziury o masie kilku milionów mas Słońca. Obserwacje trwały nieprzerwanie przez 10 dni (oko ludzkie rejestruje maks. 1/16 sekundy czasu) a ich obróbka zajmie miesiące. Ale jest to ten moment (po monitoringu być może najbliższego sąsiedztwa czarnej dziury, tzw. horyzontu zdarzeń, czyli owego Event Horizon) w którym warto wstrzymać oddech przed ujrzeniem wyników. Jak rodzą się strugi (dżety) i jak dokładnie powstaje dysk akrecyjny stanowiące „silnik“ galaktyczny? Wiemy to tylko z teorii Einsteina i obserwacji gwiazdowych dysków akrecyjnych. Do niedawna taką zagadką pozostawały fale grawitacyjne – przypuszczano że są ale potrzeba było 100 lat aby je wykryć. Tu zachodzi sytuacja jakby odwrotna – fal grawitacyjnych wszyscy się spodziewali i mniej więcej wiedziano jakich detektorów użyć żeby je wreszcie zobaczyć. Tutaj, czekamy na obraz silnika naszej Galaktyki (a także centrum galaktyki M87, jeszcze większej od naszej) aby otrzymane obrazy (jakie by nie były) „przyłożyć“ do istniejących teorii. To ostry, bezstronny, iście ogniowy test, nawet dla całej Teorii Względności.

Doktorek